Klimaatwetenschap is een complete industrie geworden met een verdienmodel, met eigenbelangen en een ingewikkeld netwerk van financiering en al het andere wat erbij hoort.

1-11-2020

De impasse van klimaatmodellering

Een gastbijdrage van Arjan Duiker.

Tijdens de wiskundeles leerde je methoden waarmee wiskundige vraagstukken kunnen worden opgelost. De toetsing beperkte zich niet tot louter een controle op het eindresultaat, maar het antwoord moest tevens worden onderbouwd met een uitwerking. De berekening toont immers aan of de gekozen methodiek geschikt is voor de aanpak van het vraagstuk en bepaalt tevens de nauwkeurigheid die kan worden behaald. Als de student de uitwerking achterwege laat en zich beperkt tot het geven van het eindantwoord, wordt dit terecht met een onvoldoende beoordeeld.

Vanzelfsprekend spelen ook in het naschoolse leven grote belangen om elkaar voldoende transparantie te bieden omtrent wetenschappelijke en technische thema’s. Belanghebbenden moeten zich immers kunnen verzekeren van een juiste aanpak. Maar hier zijn in onze complexe technologische wereld wel een aantal beperkingen ontstaan; snappen we nog wat computers doen en hoe software ze aanstuurt? Een taxatie van de beperkingen blijkt op zichzelf meestal lastig. We verliezen in toenemende mate de grip op controlemogelijkheden omdat rekenwerk binnen een black box plaatsvindt en de aansturende software voor vrijwel niemand toegankelijk is.

In o.m. de industrie is het inmiddels geaccepteerd om voor mechanische, proces technische en andersoortige berekeningen simpelweg te vertrouwen op de toepassing van softwarepakketten, ook voor modellering van dynamische systemen. Een controle beperkt zich dan tot een check op de juiste input en op de juiste instellingen. De corrigerende loop wordt gevormd door de relatief overzienbare tijd tussen theorie en resultaten uit de praktijk.

Elke computerberekening komt via een of andere numerieke wijze tot stand. Maar het fundament onder de software wordt gevormd door wetmatigheden en empirisch opgedane kennis. In de context van fluïdedynamica zijn empirisch bepaalde gereedschappen zoal: de toestandsvergelijkingen in de thermodynamica, Reynoldsgetallen die de mate van turbulentie vaststelt en Stokes-waarden voor de mate van viscositeit. Deze gereedschappen zijn ontwikkeld aan de hand van talloze proeven onder laboratoriumomstandigheden en hebben een duidelijk begrensde en gedefinieerde toepasbaarheid. Ondanks dat een rekenunit met vele malen achter de komma een antwoord kan genereren blijft de werkelijke nauwkeurigheid beperkt tot pakweg een range van 2 tot 15%, afhankelijk van de toepassing.

Hoe zit dat bij klimaatmodellen?

Wie maakt en controleert ze?

Hoe transparant is de werkwijze van de modelbouwers en gebruikers?

In hoeverre zijn ze een voldoende nauwkeurige beschrijving van de werkelijkheid?

Het lijkt een behoorlijk mistige glazen bol.

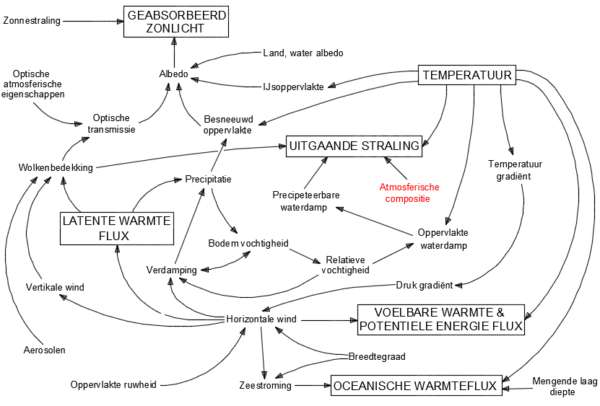

In de eerste plaats is het modelleren van een dergelijk systeem buitengewoon complex en zit vol valkuilen. Onderstaand figuur toont een versimpelde impressie van het klimaatsysteem. Het klimaatsysteem zit boordevol met niet-lineaire processen, heeft twee heel verschillende en turbulente fluïden (lucht en water) die een sterke wisselwerkingen op elkaar hebben en zich op een roterende planeet bevinden. De tijdschaal waarop processen werken varieert van milliseconden tot eeuwen. De drijvende kracht komt van de zon die het oppervlak onevenwichtig opwarmt en dientengevolge resulteert in het feit dat het klimaatsysteem nooit in evenwicht raakt. Kortom, wie durft het aan een beargumenteerde toekomstvoorspelling erover te doen?

Figuur 1: Versimpelde voorstelling van het klimaatsysteem

De in rood aangegeven variabele, de atmosferische compositie, zit op het verdachtenbankje vanwege de toenemende concentratie van CO2, een spoorgas. In de klimaatmodellen krijgt de rol van CO2 derhalve specifieke aandacht.

De atmosferische samenstelling is de afgelopen eeuw met 1/8300ste deel veranderd en al meer dan 40 jaar lang bestaat de veronderstelling dat deze verandering, of een extrapolatie ervan in de toekomst, betekenisvolle klimaatverandering zal gaan opleveren.

De daaropvolgende vraag of deze verandering netto ten gunste uitvalt of juist nadelig uitpakt is een ander thema.

Het directe effect van de CO2-toename is berekend op een jaarlijkse uitstralingsafname van de planeet van zo’n 0,04 W/m2. Anders uitgedrukt is dat een jaarlijks toenemende afwijking van 0,15 promille op de theoretische stralingsbalans. De grote uitdaging is om vast te stellen hoe en in welke mate het klimaatsysteem reageert op deze verstoring; zorgen terugkoppelingen in het systeem voor extra opwarming of dempen ze het effect juist?

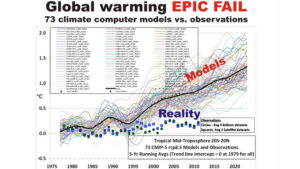

Het IPCC legt veel vertrouwen in analyses op basis van klimaatmodellen, kan er rapporten mee volschrijven en hun talloze grafische voorstellingen ogen buitengewoon indrukwekkend en waarheidsgetrouw.

Vaak wordt verondersteld dat de modellen zijn gestoeld op natuurkundige wetten, op zichzelf staande basisprincipes – de zogenaamde first principles – zoals de wetten van Newton of de wet van behoud van energie. En derhalve zou dit de robuustheid van de modellen onderstrepen. Echter, de afstand met de werkelijkheid is groot.

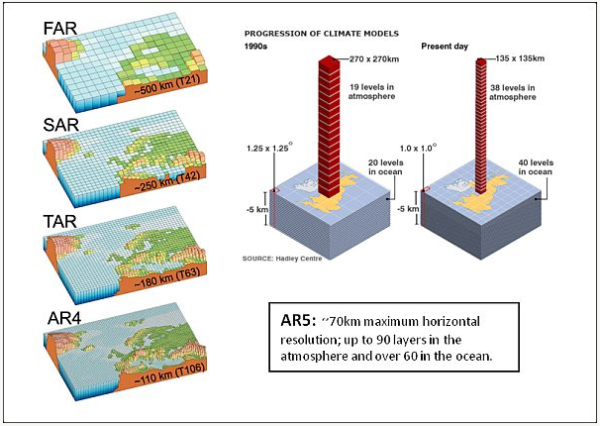

De modellen zijn opgebouwd uit eindige deeltjes die een aaneengesloten geheel vormen waarbinnen de complexe berekeningen plaatsvinden. Zie onderstaande figuur voor een impressie.

Figuur 2: ontwikkeling van de resolutie, van grof naar fijner (grid size).

De resolutie van de modellen is in de loop der jaren verfijnd en dat geeft de indruk dat de nauwkeurigheid is toegenomen. Eerdere modellen hadden een resolutie van zo’n 500 x 500 km, maar inmiddels is dat verfijnd naar een typische waarde van 100 x 100 km of kleiner en tientallen verticale lagen. Typische tijdintervallen zijn in de orde van een half uur. Dat lijkt indrukwekkend maar wat is ervoor nodig om de relevante mechanismen die plaatsvinden in de atmosfeer te kunnen beschrijven op basis van uitsluitend first principles?

In de eerste plaats moet een meer dan honderd jaar oud probleem worden overwonnen; de exacte oplossing voor de Navier-Stokes-vergelijkingen. Dat zijn de partiële differentiaalvergelijkingen die de stroming van gassen en vloeistoffen beschrijven in een 3-dimensionaal veld. Het Clay Mathematics Institute of Cambridge stelt sinds het jaar 2000 een prijs van $1.000.000 in het vooruitzicht voor degene die de oplossing of het bewijs van oplosbaarheid aandraagt. Tot op de dag van vandaag blijft het een onopgelost probleem. Middels numerieke stromingsleer valt om het probleem heen te werken maar het introduceert onder meer instabiliteit; de implicaties om die te reduceren manifesteren zich op verschillende wijze en doen afbreuk aan de nauwkeurigheid.

Vervolgens moet de resolutie naar een niveau worden gebracht waarbij de dissipatie-effecten (door visceus gedrag en inertie) de voortplanting van turbulentie op kleinere schaal voldoende tot stilstand brengt, met referentie naar de Kolmogorov relaties. Voor lucht is die schaalgrootte zo’n 1 mm. Met een dergelijk hoge resolutie en een totale verticale lengte van gesteld 20 km wordt het aantal netwerkcellen, of grid-cellen, in een klimaatmodel: 4pi(6400)2 x 20 x (106)3 = 1,03 x 1028 grid-cellen van 1 mm3

Voorts hebben we voor een honderdjarige voorspelling, op basis van een tijdsinterval van 1 seconde (arbitraire waarde), het volgende aantal tijdstappen nodig: 3600 x 24 x 365 x 100 = 3,15 x 109 tijdstappen per 100 jaar.

Stel het aantal benodigde variabelen op minimaal 10 dan resulteert dat in: 1,03 x 1028 x 3,15 x 109 x 10 = 3,24 x 1038 numerieke waarden die de computer moet verwerken.

Een supercomputer haalt een verwerkingssnelheid van pakweg 50 tera-flops (bewerkingen per seconde) en op jaarbasis is dat: 50 x 1012 x 3600 x 24 x 365 = 1,58 x 1021 flops.

De totale duur van één model-run zou dan vergen: (3,24 x 1038) / (1,58 x 1021) = 2,1 x 1017 jaar, oftewel 15 miljoen maal langer dan de leeftijd van het heelal (voor achtergrond zie Christopher Essex). Zelfs de wet van Moore, een ca. tweejaarlijkse rekencapaciteits-verdubbeling, gaat dat onvoldoende reduceren.

Dit illustreert het kolossale probleem waarmee modelbouwers worden geconfronteerd.

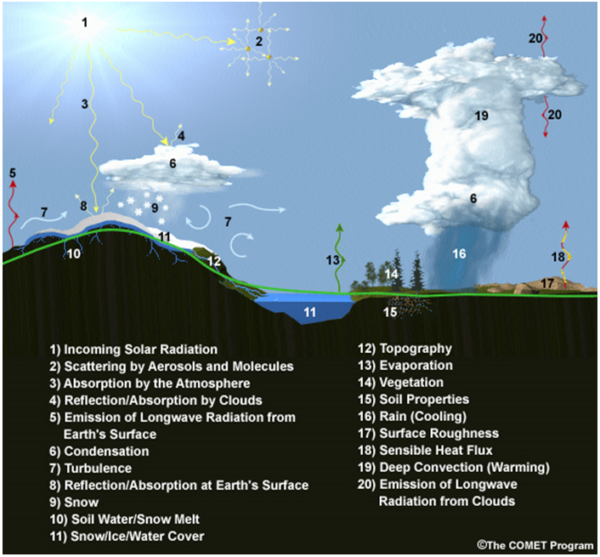

De onvermijdelijke en grote concessies die men moet maken ten aanzien resolutie en tijdsintervallen resulteren in andere uitdagingen. Processen die plaatsvinden op sub-grid niveau (dus binnen elke cel) moeten worden vervat in parameters. Dat zijn vereenvoudigde relaties die een poging doen om de karakteristieke systeemeigenschappen van werkelijke processen te benaderen. Het verwonderlijke is echter dat de schaal waarop dat binnen klimaatmodellen wordt toegepast enorm is, zie het overzicht van de aspecten die veelal worden vastgelegd met parameters in figuur 3. Vrijwel geen enkel klimatologisch fenomeen (component genoemd) ontkomt eraan.

Figuur 3 variabelen die worden uitgedrukt in parameters.

In een aantal gevallen wordt de parameter bepaald aan de hand van meer gedetailleerde sub-modellen. Maar deze zijn ‘blind’ voor elke interactie met de aangrenzende cellen in het hoofdmodel. In veel andere gevallen wordt op basis van observaties aannamen gedaan; de hoeveelheid sneeuwbedekking of de grootte van het wolkendek bijvoorbeeld. Een belangrijk deel van de natuurlijke terugkoppelingen – waarvan we zo graag willen kunnen uitsluiten of ze versterkend dan wel dempend zijn – vindt plaats op sub-grid niveau en deze omgeving wordt aldus gedomineerd door parametrisering.

Parametrisering is in feite een uitweg voor al die fysische processen die nog onvoldoende zijn begrepen of waarvan de beperkingen van een computersysteem versimpeling afdwingen. Klimaatmodellen zijn derhalve in hoge mate en in het beste geval empirische modellen. En hier doet zich één van de onoverkomelijke problemen voor. Het empirisch vaststellen van parameters met de nauwkeurigheid die recht doet aan de doelstelling om effecten van kleine verstoringen te kunnen bepalen, op de schaal van een typische celgrootte, is praktisch onmogelijk. Laboratoriumcondities om bijvoorbeeld het exacte gedrag en de impact van tropische onweerswolken te kunnen analyseren kunnen niet worden bereikt.

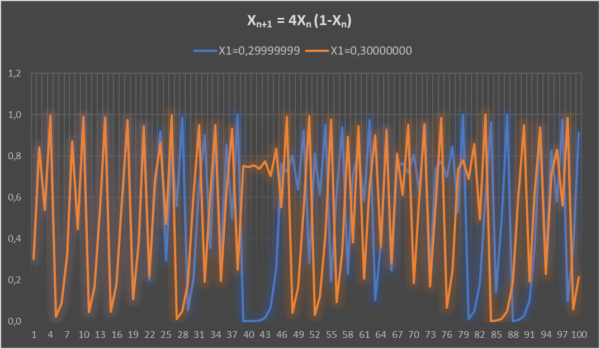

Een tweede onoverkomelijk probleem dat ermee samenhangt is het feit dat het klimaatsysteem inherent en in hoge mate chaotisch is. Een chaotisch systeem laat zich niet modelleren en al zeker niet met een nauwkeurigheid die nodig is om het effect van kleine verstoringen vast te kunnen stellen op een tijdschaal die in dit verband aan de orde is. Een heel simpel voorbeeld (zie figuur 4) die de invloed van minieme verschillen tussen initiële waarden (X1) van een chaotisch systeem doorrekent toont aan dat de responses na een zekere periode totaal verschillend worden. In het voorbeeld lopen de responses tot aan de eerste 25 stappen gelijk op, waarna elke overeenkomst zoek is. Chaotisch gedrag is de hoofdreden van de nog altijd beperkte betrouwbaarheid van weersvoorspellingen verder dan een dag of vijf, ondanks de sterk toegenomen rekenkracht.

Figuur 4 simpel chaotisch systeem.

Hoe gaat de klimaatmodellengemeenschap om met deze ernstige beperkingen?

Een survey van de American Meteorological Society uit 2014 met de titel The Art and Science of Climate Model Tuning geeft een goede indruk van de uitdagingen waarmee modelbouwers zijn geconfronteerd, maar ook van methoden die worden aangegrepen om modellen enigszins een realistische indruk te geven. Modelparameters moeten namelijk op grote schaal worden gekalibreerd, tuning noemt men dat, om de beschrijving van de werkelijkheid te benaderen. Uit het artikel wordt duidelijk dat de modellengemeenschap het ‘tunen’ tot een kunst verheft en dat zelf als zodanig kwalificeert en justificeert.

Uit het Supplement van het artikel wordt duidelijk dat tuning op vrijwel alle modelcomponenten nodig blijkt, maar met name ten aanzien van wolken en stralingsbalans. Modelbouwers zijn als het ware de diskjockeys onder de klimaatwetenschappers. Het is by the way niet erg wetenschappelijk meer. Het volgende citaat uit het artikel suggereert dat er veel trial-and-error aan te pas komt bij het klaarstomen van een model. Met andere woorden ‘probeer maar wat’.

Citaat:

“In general, the parameters are given some a priori values and ideally a range around this value. This information can come from theory, from a back-of-the-envelope estimate, from numerical experiments (tuning an eddy diffusion coefficient from explicit simulations of the turbulent process), or from obser vations (a mean effective cloud droplet for instance). Note that many internal parameters are not directly observable. Given this information, a common prac tice is to adjust the most uncertain parameters that significantly affect key climate metrics.”

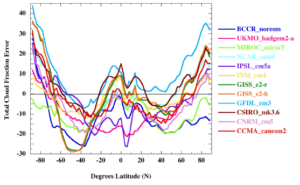

Ter illustratie van de noodzaak om tuning toe te passen is uit het volgende figuur op te maken dat de prestatie van modellen – in dit geval 12 CMIP5 modellen met een run van 1980 tot 2004 – ten aanzien van bewolkingsfractie niet in de buurt komt van de werkelijkheid. De verticale as geeft voor ieder model in procenten weer in welke mate de fractie afwijkt ten opzichte van geobserveerde waarden. De gemiddelde afwijking is 12% ten opzichte van de gemeten mondiale jaarlijkse gemiddelde wolkenfractie uit die periode.

Figuur 5 afwijkingen in gemodelleerde wolkenfracties.

Wat zegt dit nu?

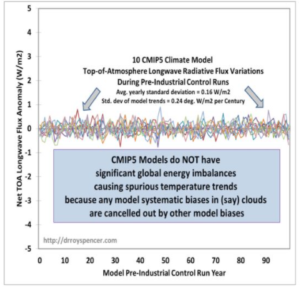

Wolken hebben wereldwijd een netto koelend effect van grofweg 20 W/m2. Een 12% afwijking vertegenwoordigt dan 2,4 W/m2. Klimaatmodellen worden getuned om de stralingsbalans sluitend te krijgen voor alle natuurlijk optredende componenten. Dit wordt onder andere aangetoond met de onderstaande analyse van dr. Roy Spencer op basis van een set aan pre-industriële controle runs over een periode van een eeuw. Het toont geen enkele toe- of afname van uitstralingsintensiteit zolang geen externe forcing (stralings-surplus door bv. antropogene CO2 effecten) aan de orde is!

Figuur 6 Top Of Atmophere afwijkingen van stralingsbalans van pre-industriele controle runs, hindcasts.

In dit voorbeeld (een typisch voorbeeld voor vele modellen) moeten één of meerdere andere variabelen worden getuned om het gat van 2,4 W/m2 te dichten en de stralingsbalans te sluiten. En bedenk, tunen is het opleggen van correcties waarvan geen reële justificatie aanwezig is.

Met de klaarblijkelijke noodzaak om parametrisering en tuning toe te passen wordt de mogelijkheid om het effect van eventuele reële fysisch geïnduceerde terugkoppelingen – van bijvoorbeeld 0,04 W/m2 forcing door CO2 toename – te kunnen analyseren (met numerieke klimaatmodellen) volledig ondermijnd. Het overschaduwt elk potentieel compenserend effect, zoals bijvoorbeeld een toename van het wolkendek met 0,2% op jaarbasis, dat zou kunnen optreden als terugkoppeling.

Klimaatmodellen zijn geprogrammeerd om uitsluitend externe forcing (CO2, vulkaanuitbarstingen, vervuiling, etc.) het effect van opwarming te geven, terwijl zonder deze externe verstoringen alle interne variabiliteit temperatuurneutraal (of beter: energieneutraal) plaatsvindt, op een tijdschaal van decennia.

Het oorzakelijk verband tussen de response van de klimaatmodelcomponenten als collectief en de externe forcing, met betrekking tot de temperatuurontwikkeling, wordt niet en kan niet door het model worden aangetoond. Zeker kwantitatief niet. En hiermee zijn we weer terug bij de ordinaire hypothese die al decennia lang bestaat:

verhoging van CO2-concentratie resulteert in opwarming, opwarming resulteert in een hoger waterdampgehalte en voorts in een waterdamp versterkt broeikaseffect.

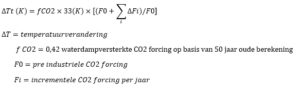

Dit is tot op de dag van vandaag nog onbewezen en leeft voort als hypothese. De complexiteit van de modellen zou in deze context sterk kunnen worden gereduceerd tot het volgende verband, dat bij wijze van spreken de kapstok vormt waaraan de modellen worden opgehangen (zie een recent artikel van Pat Frank). En voor de duidelijkheid: dit is geen fysisch bewezen verband, maar uitsluitend een rekenkundige incrementele toename van het broeikaseffect als ongecorrigeerd effect.

Men kan dus bij wijze van spreken een kwalitatief vergelijkbare projectie maken met een zakjapanner, volgens de gegeven formule. Het levert de vergelijkbare onbetrouwbaarheid op als de omvangrijke modellen. Een model, als representatie van de hypothese en al haar implicaties, heeft pas een voorspellende waarde als het is getoetst aan de praktijk. Daar hoort een omvangrijk validatieproces bij dat in het geval van klimaatonderzoek vele decennia tot eeuwen de tijd zou vergen.

Modelbouwers hebben de opvatting dat het tunen van hun model naar het verleden toe, de zogenaamde hindcasts, de voorspelbaarheid ten goede komt. Echter, met de chaostheorie in gedachte is de respons van het echte klimaatsysteem op de toenmalige omstandigheden uniek geweest. Elke kleine afwijking had een ander klein of groter effect gehad op het verloop. Bovendien leidt het tunen van parameters die een gepasseerde fysische toestand moeten beschrijven tot een slechter voorspellend model, immers; tunen is een overbrugging tussen gemodelleerde output van een desbetreffend modelcomponent, door de parameter, en de werkelijke toestand die op componentniveau helemaal niet bekend was. Zo zijn bijvoorbeeld albedo, relatieve vochtigheid of wolkenbedekking niet in voldoende mate, dan wel geenszins, bekend over de periode van de hindcast.

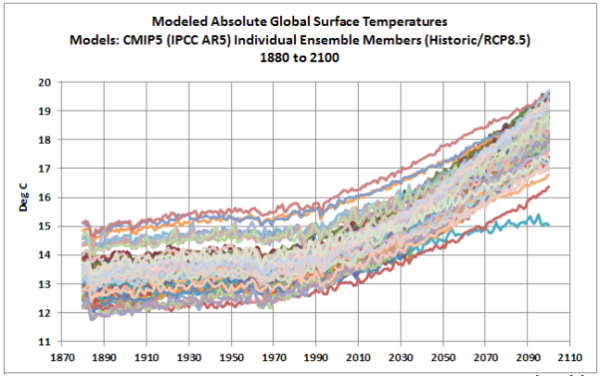

Een volgende aanwijzing waaruit blijkt dat modellen onvoldoende nauwkeurig zijn en zelfs buiten the ball-park presteren, is het gebrek aan waarheidsgetrouwe benadering van een absolute temperatuur (°C in deze context). Een analyse van modelresultaten (uit CMIP5) over de periode 1880 tot 2100 toont een spreiding met een bandbreedte van ruim 3°C, zie figuur 7. Bij een gebruikelijke weergave van temperatuuranomalie ten opzichte van een historische trend, scoort een afzonderlijk model vele malen beter en de samengestelde trend ligt ogenschijnlijk vaak in de buurt van het werkelijke verloop. Maar dat maskeert het feit dat het ene model 15°C berekent terwijl het andere 12°C, voor hetzelfde tijdstip. Het IPCC is er oorverdovend stil over maar het verklapt uiteraard het onvermogen van modellen om de fysische werkelijkheid te benaderen; een antropogeen signaal valt volledig weg in de ruis die de afwijkingen op modelcomponentniveau kennelijk veroorzaken.

Figuur 7 CMIP5 individuele modelruns, bron Bob Tisdale voor WUWT.

Uit het bovenstaande valt af te leiden dat het beschikbare gereedschap, de detailkennis van de fysische wereld en de observationeel verkregen data tekort schieten om voldoende nauwkeurig te kunnen modelleren noch modellen van de juiste input te kunnen voorzien.

Welke strategie volgt de klimaatwetenschap als gemeenschap om dat het hoofd te bieden?

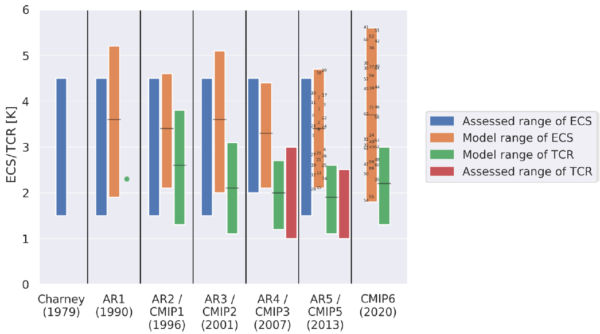

Dat laat zich afleiden aan de ontwikkeling die deze industrie heeft doorgemaakt. In een notendop komt het hierop neer: In 1967 brachten Manabe and Wetherald het eerste rapport uit waarin een schatting werd gegeven voor de zogenaamde Equilibrium Climate Sensitivity, kortweg ECS; een maat voor de uiteindelijke opwarming als gevolg van een verdubbeling van de CO2-concentratie, met 2,4°C als opgegeven waarde. In 1979 werd, in vijf dagen tijd, het Charney Report opgesteld waarbij een ECS-range van 2°- 4,5°C werd opgegeven.

Sindsdien heeft zich een tendens ontwikkeld die een complexiteitstoename en een wetenschappelijke expansiedrift vertoont die de progressieve trend van de meest extreme klimaatscenario’s laat verbleken. Het World Climate Research Programme (WCRP) staat hierin centraal met betrekking tot klimaatwetenschap op basis van modellering. Deze organisatie, net als het IPCC die hun modellen gebruikt, doet niet aan eenvoud. Het programma omvat een groot aantal projecten en nog veel meer afgeleide projecten, elk aangestuurd door een eigen stuurgroep, een globaal en regionaal comité en talloze werknemers. Men verzorgt presentaties, workshops, trainee-ships, organiseert wereldwijd events, vergadert, doet experimenten, ontplooit activiteiten, publiceert en brengt magazines op de markt en newsletters, enzovoorts. En dat allemaal met onvoorstelbare omvang.

Het WCRP regisseert tevens het Coupled Model Intercomparison Project (CMIP). Dat is een gestandaardiseerd protocol voor resultaatanalyses van modellen. Dit jaar zijn voorlopige resultaten van de zesde fase van het project beschikbaar gekomen, CIMP6. Aan het programma werken maar liefst 49 modelling groups mee en zij hebben elk een groot aantal programmeurs en wetenschappers in dienst. Ter ondersteuning van het programma is indrukwekkende lijst aan projecten zijn in het leven geroepen om het CMIP-project zo omvangrijk mogelijk in te richten, met de hoop dat modellen er beter van gaan presteren.

Wat het geheel volstrekt duidelijk maakt is dat er geen sprake meer is van een traditioneel wetenschappelijk veld. Klimaatwetenschap is een complete industrie geworden met een verdienmodel, met eigenbelangen en een ingewikkeld netwerk van financiering en al het andere wat erbij hoort.

Klimaatmodellen worden inmiddels Earth System Models genoemd, wederom indrukwekkend. De bewegingsrichting van de klimaatgemeenschap is zonneklaar: men poogt met een eindeloze hoeveelheid onderzoek en modellering het gehele klimaatsysteem (en ten dele het ecosysteem) tot in de kleinst mogelijke details in een computermodel te vatten, om vervolgens alle kwesties te kunnen duiden en van advies te kunnen voorzien. De totale uitgaven van een halve eeuw aan klimaatonderzoek, overhead, lobby en bureaucratische excessen wordt geraamd op tientallen miljarden dollars. En de hele beweging komt nu pas lekker op stoom. Hou je dus vast…

Maar wat heeft deze ontwikkeling ons vandaag de dag opgeleverd? Onderstaand figuur geeft de klimaatgevoeligheid weer die werd gepubliceerd bij elke mijlpaal in de ontwikkeling van deze wetenschap. En voor de duidelijkheid, dit betreft slechts onderzoek dat door het IPCC wordt beaamd. De teleurstellende waarneming is dat de ECS-range sinds het Charney-rapport zo goed als ongewijzigd is gebleven en zelfs in range is gegroeid! De ECS ligt nu in de enorme range van 1,8° – 5,6°C. De ondergrens van de TCR-range (temperatuurstijging vlak nadat de CO2-verdubbeling is bereikt, ongeveer na 70 jaar op basis van 1% jaarlijkse toename) is 1,3°C; een getal dat in buurt ligt van observationele studies.

Figuur 8 ontwikkeling ECS/TCS waarden (bron).

Welke bescheiden conclusies mogen we nu trekken?

- Een inherent chaotisch en hyper complex systeem is a priori niet succesvol in een voorspellend model te vatten.

- Het gereedschap (de computer), de kennis en de data zijn te gebrekkig om een klimaatmodel te laten werken op basis van de robuuste first principles.

- Modellen leunen voor een belangrijk deel op parametrisering dat vele ‘handmatig’ opgelegde correcties behoeft (dat men tunen noemt, een zelf bestempelde ‘art of climate science’) en dat vervolgens detecteerbaarheid van eventuele reële fysisch geïnduceerde terugkoppelingen, van oorzakelijk verband dus, onmogelijk maakt.

- Verfijning van parameters naar het benodigde niveau vereist een oneindige onderzoeksinspanning en kan vanwege de omvang en schaalgrootte van het klimaatsysteem nooit worden bereikt.

- De beweging naar een voldoende fijnmazige modelstructuur die vertroebeling ten gevolge van parametrisering voorkomt loopt tegen de harde grenzen aan van beschikbare rekenkracht, ook op termijn.

- Dit resulteert in een impasse.

De grote en inmiddels toegenomen ECS-range is zo langzamerhand gênant aan worden. Klimaatmodellen modelleren het klimaat niet. Ze zijn niet en kunnen niet gevalideerd worden. Ze hebben geen, maar dan ook geen enkele, voorspellende waarde als het gaat om de invloed van de mens als gevolg van het gebruik van fossiele brandstoffen. Het IPCC noemt de output van modellen derhalve projecties. Ofwel, we hebben ons best gedaan, we weten het niet maar desondanks presenteren we graag onze modellenrange, het product van onze dure computer. En we willen graag nog een aantal decennia studeren. Mogen wij nu onze rekening indienen!?

Arjan Duiker.

En daarmee roept het een andere invalshoek op die de enorme ECS-range wellicht verklaart. Het biedt het IPCC namelijk de gelegenheid om tegelijkertijd:

- alarmistisch te kunnen blijven of het zelfs te kunnen bekrachtigen;

- de best estimate op vergelijkbaar niveau te houden met voorgaande mijlpalen en daarmee de indruk te wekken dat het een aanscherping betreft, een verbetering;

- de ondergrens in overeenstemming te laten lijken met de observationele getalswaarden, dus men kan later altijd claimen accuraat te zijn geweest;

- de motivering om het onderzoek voort te willen zetten te onderbouwen (want afschalen is natuurlijk tegen het belang van de gemeenschap in).

Maar los van elk klimaatmodelresultaat staat: het interesseert ons geen bal of de IPCC-projecties in overeenstemming zijn met de werkelijke temperatuurtrend, in de tijd vooruit of achteruit bezien. We willen begrijpen of hun aanpak valide is. En alles wijst erop, die is niet valide.

Beste klimaatmodelbouwers: stop vandaag met modelleren, jullie krijgen de modellen wel ingewikkelder, niet betrouwbaarder, bespaar de omvangrijke inzet van kostbare resources, lik je wonden, behoed je voor een complete afgang maar bovenal, herzie je methodiek. Jullie zitten in een impasse.

Dolf van Wijk over de waarheid over wetenschappelijke modellen

Voor een wat andere invalshoek over modellen, zie hier:

0 reacties :

Een reactie posten